Tout au long de sa carrière, l’informaticien aurait besoin d’apprendre plusieurs compétences. C’est dans la plupart des cas des compétences qu’aurait à utiliser presque au quotidien. Ils ne sont pas totalement obligatoires mais il serait pour lui difficile de les contourner.

1. L’algorithmique et structure de données : cette partie concerne beaucoup plus les développeurs, mais la compréhension de comment un ordinateur fonctionne est indispensable. Il faut se rappeler qu’un ordinateur est une machine comme une autre, sa particularité est de traiter l’information à la place de la matière comme les autres machines. Ainsi les structures de données permettent la compréhension de l’organisation de l’information. Et l’algorithmique, la manière dont les données sont traitées par la machine.

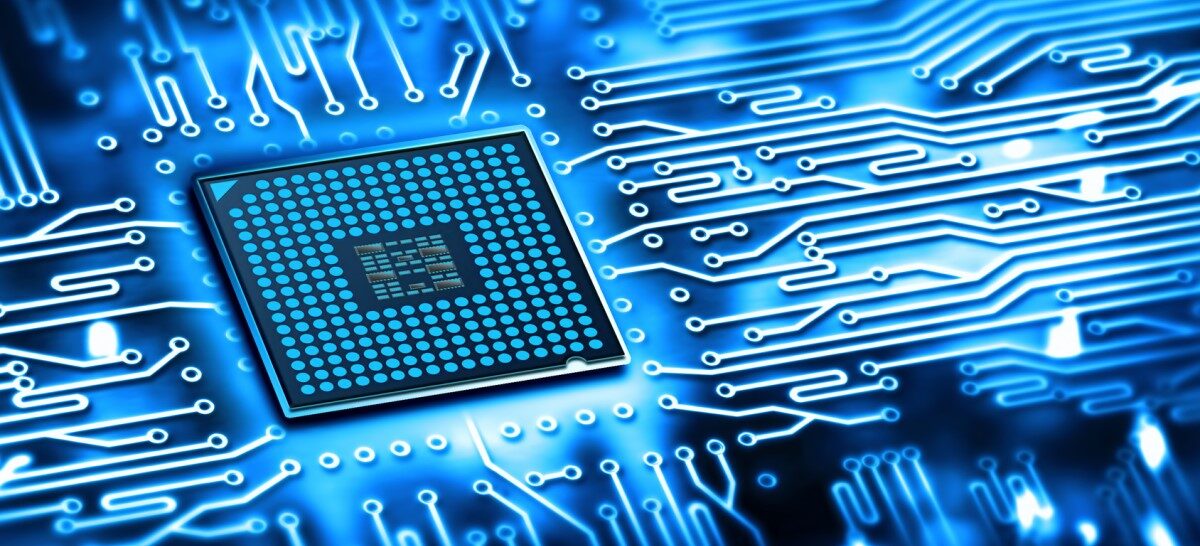

2. Le hardware et matériel physique : dans cette partie l’informaticien doit avoir une perception globale de la composition physique hardware d’un ordinateur. Entre autres, les composantes essentielles d’un ordinateur, comme par exemple, le processeur, la RAM, le disque dur, la carte mère, la carte graphique…etc. De comprendre leurs caractéristiques et de pouvoir les remplacer et changer leurs paramètres.

3. Les outils de bureautique : ou autrement appelés, les outils office en référence à Microsoft Office. C’est généralement les outils qui vous permettent d’écrire et formater du texte et de l’imprimer avec Microsoft Word par exemple. De remplir des tableaux avec des fonctions basiques de statistiques et de diagrammes avec Microsoft Excel. De préparer des présentations pour les exposer dans des réunions avec Microsoft PowerPoint. Ou rédiger des rapports techniques bien structuré avec Latex.

4. Langages de programmation : Cette partie aussi concerne principalement les développeurs, mais généralement un informaticien aurait au moins à maîtriser un ou deux langages de programmation. Pour la maîtrise totale d’un langage de programmation, beaucoup de temps et d’expérience sont nécessaires. Appréhendé de fond en comble un langage de programmation est relativement difficile.

5. Linux : Linux n’est pas un système d’exploitation comme les autres, on peut dire qu’il est spécifique et bien taillé aux informaticiens. Contrairement à Windows qui est un système d’exploitation grand public, Linux est plus technique. Il permet à son utilisateur aguerri de faire ce qu’il veut avec ce système d’exploitation. Il peut le modifier comme il lui semble, dans le sens où il peut changer la structure interne du système pour s’adapter au hardware et au besoin de l’application. Il est aussi très adapté au processus intrinsèque à l’administration et le contrôle des machines, comme l’automatisation, la sauvegarde et le backup, la sécurité, le monitoring…etc.

6. Le Web : savoir utiliser le web comme un simple utilisateur. Et surtout reconnaître les bases de fonctionnement du web, comme les protocoles (html, http, ftp, ssl, tls…etc). Les serveurs (serveur web, serveurs de base de données, serveurs d’authentification, serveurs de clés de chiffrement…etc.). Les langages de programmation (html, css, php, javascript, ruby…etc.). La pile de développement des applications web avec ses 2 parties principales le front-end et le back-end. Les API et les services web…etc.

7. Les réseaux informatiques : comprendre le fonctionnement d’un réseau informatique et aussi très importante pour l’informaticien. Comprendre les bases sur le fonctionnement d’un réseau que ça soit filaire ou sans fil. Que ça soit un simple réseau local à la maison, ou un réseau plus grand envergure englobant toute une entreprise. Reconnaître les protocoles utilisés et le processus de l’encapsulation de l’information à travers les couches OSI…etc.

8. La sécurité informatique : dans un monde presque entièrement digitalisé l’information fait face à plusieurs menaces, dont le vol, la substitution, la corruption, la destruction…etc. Ainsi, il devient indispensable pour un informaticien de savoir protéger l’information, c’est comme installer des systèmes de sécurité dans sa maison. Dans ce domaine l’informaticien doit savoir comment sécuriser ses machines et son réseau, comment créer des mots de passe robustes, ne pas tomber dans les pièges des pirates, reconnaître les liens ou les emails ou les messages à risque…etc.

9. L’administration des serveurs et le cloud : savoir contrôler les serveurs ou des machines distantes fait aussi partie des compétences inhérentes à un informaticien. Dans ce cas de figure, les machines sont souvent assez puissantes, ce sont généralement des serveurs à plusieurs milliers de kilomètres de distance. Qui sont uniquement accessibles par la voie du réseau, ce qui rend leur utilisation particulière et différente d’un simple PC. Le cloud c’est pratiquement la même chose mais au lieu de contrôler des serveurs vous aurez à contrôler tout un système logiciel et matériel interconnecté, ce qui rend le processus encore plus complexe.

10. Les outils de communication et les réseaux sociaux : pour les outils de communication il y en a du plus simple comme les emails et les logiciels de messagerie instantanée (Skype, Messenger, WhatsApp ou Viber), au plus sophistiqués comme Discord et mIRC. Les réseaux sociaux de l’autre côté sont à double tranchant, ils peuvent être néfastes par leurs addictions et le bafouillage des meurs et de la vie privée. Et de l’autre côté, le plus simple moyen actuel de s’ouvrir au monde et d’accéder à des milliers voire des millions de personnes.

On a pu voir sur ces points quelques connaissances indispensables pour un informaticien tout au long de sa vie professionnelle. On pourrait aussi rajouter la maîtrise des outils de l’intelligence artificielle, néanmoins ça reste un domaine assez récent et pas encore mature. Dans tous les cas, il faut savoir que les connaissances de l’informaticien ne se résument pas à ces quelques points, à vrai dire, tout au long de sa carrière l’informaticien ne va pas cesser d’apprendre.